大语言模型出现的时候,我们惊叹于一个模型就能够流畅对话、撰写文章、解答疑问,这种“通才”式的表现足以令人震撼,这也是所谓大模型的“大”的含义,它似乎能够包罗万象,完成所有人类交给它的任务。

然而,随着技术的迭代与应用场景的深化,我们观察到:

单一、庞杂的模型架构已难以满足所有任务对精度、深度和可靠性的极致要求。因此,大语言模型领域开始出现显著的能力分化,如同生命进化中的物种分化一般,催生出了一系列在特定方向上表现卓越的“专家型”模型。

这些分化出的能力,不仅仅是技术指标的提升,更是AI真正融入并重塑我们工作与生活方式的基石。其中三项最引人注目的能力:聊天能力、推理能力和智能体能力,它们之间的微妙关系影响着未来的趋势。

聊天能力:人机交互的基石与沟通的艺术

聊天能力,即语言理解与生成能力,是大语言模型最基础、也是最先为公众所熟知的能力。它构成了人机自然交互的桥梁,其核心在于“理解”与“表达”的精准闭环。

核心内涵:

这远非简单的关键词匹配或模板回复。现代顶尖的聊天模型,如GPT-4o,具备深层次的语义理解能力。它能捕捉用户输入中的上下文、情感色彩、隐含意图乃至文化背景。在生成端,它不仅能保证语法的正确性,更能模仿人类的修辞手法、调整文风语调,生成连贯、得体且富有信息量的高质量文本。

技术实现浅析:

这种能力源于对海量高质量文本和代码数据的训练。模型通过学习数以万亿计的词汇关联、语法结构和逻辑链条,构建了一个复杂的“概率世界模型”。当接收到新输入时,模型会基于这个内部模型,预测出最合乎情理、最符合语境的下一个词、下一句话,直至完成整个回复。这就像一个学识渊博且反应迅捷的对话者,能够瞬间调用其知识库,组织语言进行回应。

简单例子:

假设用户输入:“我最近工作压力好大,项目截止日期快到了,感觉有点喘不过气。”

- 初级模型的回应可能是:“建议你放松一下。”——这是一个正确但空洞、缺乏共情的回答。

- 具备高级聊天能力的模型(如GPT-4o)的回应则可能是:“听起来你真的处在高压之中,临近截止日期确实会让人感到焦虑。或许可以尝试将项目分解成几个小任务,逐个击破,这样会感觉可控一些。记得也要安排短暂的休息,起来走动一下,喝杯水。加油,你能挺过去的!”

- 分析:这个回复首先进行了情感认同(“听起来你真的处在高压之中”),表明它理解了用户的情绪。其次,它提供了具体、可操作的建议(分解任务、短暂休息),展示了基于常识的推理。最后,它使用了鼓励性语言(“加油,你能挺过去的!”),体现了拟人化的沟通技巧。整个过程流畅、自然,极大地提升了用户体验。

聊天能力是AI平民化的关键,它使得任何人都能以最自然的方式——语言,来获取信息、寻求陪伴和辅助创作。

推理能力:从“记忆”到“思考”的质变

如果说聊天能力体现了AI的“博学”,那么推理能力则彰显了其“智慧”。推理能力,即逻辑推理能力,使模型能够解决需要多步骤分析、逻辑演绎和问题分解的复杂任务,如数学证明、编程调试和复杂规划。

核心内涵:

推理能力的本质是让模型的学习过程从“模式匹配”转向“逻辑演算”。它要求模型不仅知道“是什么”,还要理解“为什么”,并能够规划出“怎么做”的路径。

技术实现的关键:链式思考

推理能力的飞跃,很大程度上得益于链式思考(Chain of Thought, CoT) 技术的应用与强化。CoT要求模型在给出最终答案前,将其内部的思考过程一步步地、以自然语言的形式展示出来。这类似于小学生在解数学应用题时写下“解:”和一步步的演算过程。这种做法带来了两大好处:

- 对模型自身而言:强制其进行循序渐进的逻辑推演,避免了“直觉式”的跳跃性错误,提高了答案的准确率。

- 对使用者而言:思考过程变得透明、可追溯,我们不仅可以验证答案的正确性,更能理解模型得出结论的逻辑,从而建立信任,并在模型出错时精准定位问题所在。

以DeepSeek R1和传闻中的o1为代表的推理模型,通常在其训练或推理机制中深度整合了CoT,甚至采用了“系统2思维”式的慢思考架构,通过反复推演来确保结果的可靠性。

简单例子:

问题:“一个房间里有三盏灯,门外有三个开关A、B、C,分别控制这三盏灯。你只能进房间一次。如何确定哪个开关控制哪盏灯?”

- 仅有聊天能力的模型可能会直接猜测一个答案,或者复述它从训练数据中看到过的类似谜题,但缺乏严谨的推导。

- 具备强大推理能力的模型(如DeepSeek R1) 的思考过程可能是:

- 第一步(分析约束):关键限制是“只能进房间一次”,这意味着我必须利用灯除了“亮”和“不亮”之外的另一种状态来传递信息。

- 第二步(引入中间状态):我知道灯泡在关闭后的一段时间内还会保留余热。这是一个可以利用的物理属性。

- 第三步(设计实验):我可以先打开开关A,等待5分钟后关闭它,然后立即打开开关B,并马上进入房间。

- 第四步(观察与推理):

- 现在亮着的灯肯定是由开关B控制的。

- 用手去摸另外两盏不亮的灯:那盏还热着的灯,是由刚才打开过又关掉的开关A控制的。

- 那盏既不亮也不热的灯,就是由从未打开过的开关C控制的。

- 最终答案:通过温度和亮度的组合状态,在一次进门后就能完成判断。

这个例子清晰地展示了推理能力所需的规划、引入中间变量和逻辑链条构建。在编程领域,这种能力表现为将复杂需求分解为函数、模块,并处理各种边界条件;在数学领域,则表现为严谨的定理证明和公式推导。

Agent能力:从“助手”到“代理”的跃迁

Agent能力,即自主规划与执行任务的能力,是大模型分化中最具革命性的一环。它标志着AI从被动的“问答机”转变为主动的“执行者”。一个具备Agent能力的模型,能够理解一个高阶的、复杂的目标,自主制定计划、调用工具、执行步骤,并在遇到障碍时动态调整策略,直至任务完成。

核心内涵:

Agent的核心是“行动”。它赋予了大模型“手”和“脚”,使其能够与外部世界(其他软件、数据库、互联网等)进行交互。其工作流程可以概括为:“思考-行动-观察-再思考”的循环。

技术实现浅析:

Agent模型通常内置一个“规划器”。当接收到用户指令(如“为我策划一个下周末的北京三日游”),规划器会首先将目标分解为一系列子任务:

- 查询北京的天气。

- 搜索热门景点并规划行程路线。

- 查找并对比酒店和机票价格。

- 生成一份详细的预算和日程表。

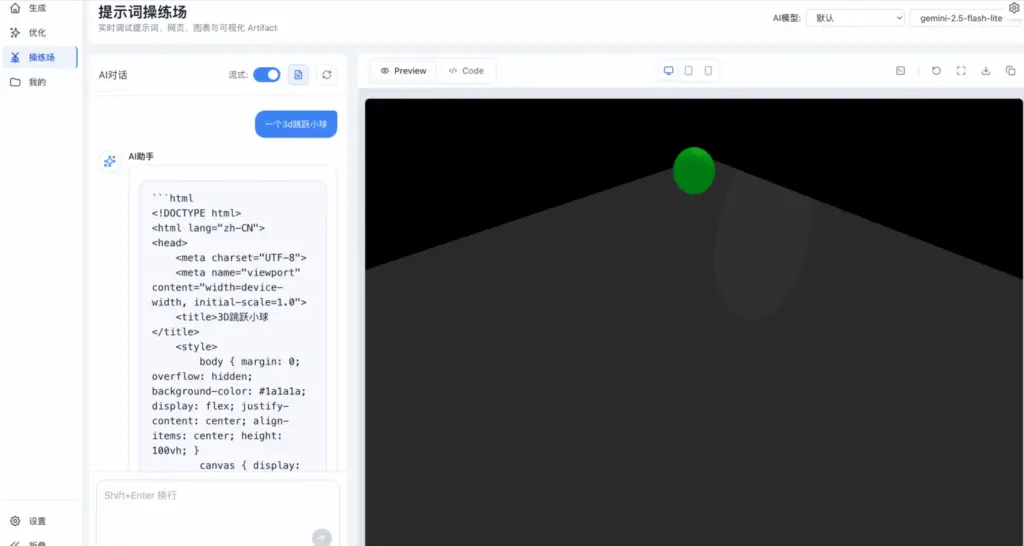

随后,模型会主动调用相应的工具来执行每个子任务:调用搜索引擎API查询天气和景点,调用订票平台的接口获取价格信息,最后调用自身的文本生成能力整合所有信息,形成报告。Claude 4系列和传闻中的GPT-5正是这方面的佼佼者,国内的豆包Seed 1.6、DeepSeek V3、GLM 4.5、Kimi K2、Qwen-Coder等模型也在快速追赶,尤其在代码执行、数据分析等垂直领域的Agent表现突出。

简单例子:

用户指令:“帮我分析一下公司上季度销售数据Excel表格,找出销售额最高的三个产品,并为每个产品写一段100字左右的营销亮点描述。”

- 不具备Agent能力的模型:可能会回复:“我无法直接处理Excel文件,请您将数据复制粘贴给我。”或者,如果它接受了文件,也可能因为缺乏代码执行能力而无法进行复杂的数据分析。

- 具备Agent能力的模型(如Claude 4):

- 规划:它意识到这个任务需要“数据分析”和“文案创作”两个步骤。

- 行动:

- 它首先会调用一个内置或外部的Python代码解释器,将Excel文件加载为DataFrame。

- 然后执行排序、分组等操作,精准找出销售额TOP3的产品及其关键数据。

- 观察:代码解释器返回了结果,例如“产品A,销售额500万;产品B,销售额450万;产品C,销售额400万”。

- 再思考与行动:模型基于这些数据,调用自身的文本生成能力,为每个产品撰写一段突出其销售业绩和市场地位的营销描述。

- 交付:最终向用户呈现一份包含清晰数据结论和高质量文案的完整报告。

这个过程完全自动化,用户只需下达一个指令,即可坐享其成。Agent能力是实现“数字员工”自动化办公、构建高度智能应用生态的核心。

能力的冲突与未来的融合:通用人工智能的必经之路

一个有趣且关键的现象是,这些卓越的能力在当前的模型架构下,并非总是和谐共存的。它们之间存在着微妙的“冲突”或“权衡”。

- 案例剖析:正如您所观察到的,Gemini 2.5 Pro在代码能力和写作能力上都非常强悍,但其Agent能力(如规划、工具调用的稳定性和效率)却相对一般。这导致基于它构建的Gemini CLI工具在自动化任务中的表现平平。反之,GPT-5和Claude 4的Agent能力被业界公认极为强大,能够稳健地完成复杂任务链,但它们在纯粹的、需要文学美感的文章写作上,表现反而不如一些专精于此的模型,甚至有用户吐槽GPT-5写出来的文章“简直没法看”。

这种分化与冲突的根源在于模型架构、训练数据和训练目标的侧重不同。

- 一个极致的聊天/写作模型,可能需要更多侧重于文学、创意、对话的数据和训练目标,以优化其语言的流畅性和创造性。

- 一个极致的推理模型,可能需要融入更多的数学、逻辑和代码数据,并采用CoT强化训练,其“思维”模式更倾向于严谨和缓慢。

- 一个极致的Agent模型,其核心是学习如何高效、准确地规划和调用工具,其训练可能大量依赖于与模拟环境的交互和强化学习。

让一个模型同时成为李白、爱因斯坦和一个不知疲倦的CEO,在当前的技术范式下,对算力、数据和算法都构成了巨大的挑战。这就像要求一个运动员同时是奥运举重冠军和芭蕾舞大师,虽然并非完全不可能,但需要极其特殊和均衡的设计。

未来的发展趋势,无疑是向更通用、更均衡的方向演进。 用户渴望的是一个“全能王牌”:它既能像挚友一样与你深入谈心,又能像科学家一样解决专业难题,还能像私人助理一样包办一切杂务。目前,GPT-5正在这个方向上做出勇敢的尝试,试图弥合这些能力鸿沟,打造一个更为均衡的通用智能体,但从各方评测来看,它尚未完全成熟,在某些单项上仍需向更“专精”的模型看齐。

业界普遍将希望寄托于下一代模型,如GPT-6。我们期待它能通过革命性的架构创新(如更高效的混合专家模型)、更高质量和多样性的训练数据、以及更先进的训练算法(或许能更好地协调不同能力目标),最终实现这些卓越能力的“大一统”。届时,大模型将不再仅仅是工具,而是成为一个真正通用、可靠、值得信赖的智能伙伴,深刻地嵌入人类社会运行的每一个角落。

结语

大模型的能力分化,是技术深度发展的必然阶段,是AI从“玩具”走向“工具”乃至“同事”的证明。聊天能力让我们沟通无碍,推理能力让我们信赖其判断,Agent能力则让我们得以解放双手。尽管当前存在能力的权衡与冲突,但这正是技术螺旋式上升过程中的正常现象。对分化能力的深入理解和专项应用,正为我们创造着当下的价值;而对通用与均衡的不懈追求,则指引着通往未来的道路。这场从“通才”到“专精”,并最终回归到更高级形态的“通才”的进化之旅,无疑是人工智能时代最壮丽的景观之一。

关注本站公众号,手机也能随时看

原创文章,作者:猫捉,如若转载,请注明出处:https://www.meowzo.com/the-evolution-of-large-models-from-general-purpose-to-specialized/