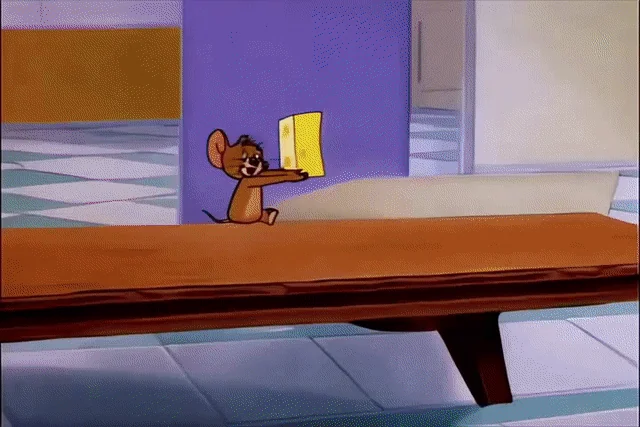

最近啊英伟达放出了一个超有趣的视频,他们把经典动画《猫和老鼠》用AI重新制作了一遍,这视频一发布就在网上火得一塌糊涂,大家都在疯狂转发、讨论。

你想象一下,只要给AI一个提示,不用你动手剪辑,它就能帮你创作出《猫和老鼠》的动画,而且一次能生成60秒的视频呢!这就像是给你的童年回忆无限续杯,让你一次看个够!

这个神奇的“一分钟视频”生成器,是英伟达、斯坦福、UCSD这些大机构的研究者们一起搞出来的。它的原理特别简单,就是在预训练的Transformer模型里加了一个TTT层,这样,一个只有5B大小的小模型就能理解复杂的提示,然后生成长达1分钟的视频了!是不是很厉害?

论文地址都给你们准备好了:https://test-time-training.github.io/video-dit/,感兴趣的朋友可以去看看。

接下来,准备好,一大波精彩的童年经典全新故事来袭!

汤姆正在厨房的桌子旁,美滋滋地吃着苹果派,结果一开门,苹果派就被杰瑞偷走了。然后,汤姆和杰瑞就开始了一场你追我赶的大战,最后杰瑞成功逃脱,汤姆却一头撞到了墙上。

还有啊,杰瑞在水下找到了一张藏宝图,它成功躲过了汤姆的追捕,然后在沉船里发现了宝藏。可是,正当它开心庆祝的时候,汤姆又追了上来,结果它遇到了一条饥饿的鲨鱼,这下可麻烦了!

这些视频效果太生动、太精妙了,就像一枚炸弹在AI创作圈炸开了锅,大家都被震撼到了。

有意思的是,当我们去深入了解这个技术背后的秘密时,发现这个火遍全网的研究,竟然是建立在一个来自智谱AI的国产大模型上的!

具体来说,研究者们用了预训练的CogVideo-X 5B作为基础模型,然后在这个模型里加上TTT层,再进行微调。就这么简单几步,就生成了上面那些让人惊叹的视频效果。

CogVideoX-5B亮相即爆火

这个CogVideo-X系列的图生视频模型,早在去年8月开源的时候,就在AI圈里引起了不小的轰动。它结构简单又可扩展,包含一个3D因果VAE和一个专家Transformer,能生成连贯、长时长、动作丰富的视频。

这个模型支持多种宽高比,分辨率高达768×1360,长度能达到10秒,帧率是16fps。而且,它还是首批商业级开源的视频生成模型,有5B和2B两种规模,包括文本到视频和图像到视频两个版本。

你只要输入一张图像和提示词,比如输入一张狗狗的图片,然后配文“开心狗狗”,一只张嘴微笑的开心狗狗视频就生成了。

而且啊,CogVideoX-5B的视频生成效果在当时就已经足够惊艳了。比如一只狗在雨中奔跑,还戴着墨镜,地面上的倒影都特别真实。还有外星人与宇航员握手这种未来科幻的场景,以及满是蝴蝶和喷泉的精美画面,它都能实现。

这个模型在工程优化上也做得相当不错。它支持多种推理精度,推理显存需求最低只有11.4GB,用一张3060显卡就能完成推理。LoRA微调显存需求是63GB,SFT微调是75GB,用一张A100(80GB)显卡也能轻松完成微调任务。

后来啊,智谱团队又在11月开源了能力更强的CogVideoX v1.5,包括CogVideoX v1.5-5B和CogVideoX v1.5-5B-I2V两个版本。跟CogVideoX-5B比起来,CogVideoX v1.5能生成5/10秒、768P、16帧的视频,I2V模型还支持任意尺寸比例,图生视频的质量和复杂语义理解能力都大幅提升。

现在啊,CogVideo和CogVideoX系列模型已经在GitHub上获得了11.2k个星,受到了大家的广泛认可和喜爱。开源项目地址也给你们准备好了:https://github.com/THUDM/CogVideo。

创新架构,刷新SOTA

这个团队啊,一直在不断创新和突破。为了解决视频生成模型运动幅度有限、持续时间较短的问题,特别是基于文本生成具有连贯叙事性的视频这个难题,他们提出了很多创新性的设计。

首先呢,他们设计并训练了一个3D因果VAE,在空间和时间维度上对视频进行压缩,实现了高维视频数据的高效处理。跟以前微调2D VAE的方法比起来,这种策略不仅减少了序列长度和相关训练计算量,还能防止生成视频中的闪烁,确保帧间的连续性。

其次呢,为了改善视频与文本间的对齐效果,他们提出了一种带有专家自适应LayerNorm的专家Transformer,促进了两种模态的融合。为了确保视频生成中的时序一致性并捕捉大范围运动,他们还建议使用3D全注意力机制,在时间和空间维度上对视频进行全面建模。

另外啊,因为在线可用的大多数视频数据都缺乏准确的文本描述,所以他们开发了一个能准确描述视频内容的视频描述生成流程。通过为所有视频训练数据生成新的文本描述,CogVideoX精确理解语义的能力得到了显著提升。

他们还设计了渐进式训练技术,包括多分辨率帧打包和分辨率渐进式训练,进一步提升了CogVideoX的生成性能和稳定性。还提出了显式均匀采样方法,通过在每个数据并行单元上设置不同的时间步采样间隔,稳定了训练损失曲线并加速了收敛。

对于生成时间较长的视频,一些模型可能会为了获得更高分数而产生帧间变化极小的视频,但这类视频缺乏丰富的内容。为了解决这个问题,他们使用了两种视频评估工具:动态质量和GPT4o-MTScore。前者通过结合多种质量指标与动态得分,减轻了由视频动态性与视频质量之间负相关所带来的偏差;后者则是通过GPT-4o来测量视频内容的变化程度。

结果显示啊,CogVideoX-5B不仅在视频生成质量方面表现出色,而且在处理各种复杂动态场景方面也优于先前的模型。在7项指标中有5项取得了最佳性能,在其余2项指标上也名列前茅。在VAE重建效果方面,CogVideoX-5B取得了最高的PSNR值和最低的抖动。

开源社区,全是「二创」

因为CogVideoX性能出色,现在不少项目都已经适配了它。在官方的Github页面上展示了十几个使用CogVideoX的开源项目链接,其中不乏一些实用、知名的项目。

比如下面这个DiffSynth-Studio开源项目,已经获得了8.3k个星了。这个项目在CogVideoX-5B生成的视频基础上进行编辑和帧插值操作,以达到更好的效果。

项目地址:https://github.com/modelscope/DiffSynth-Studio?tab=readme-ov-file

还有KoolCogVideoX,这是一个基于CogVideoX的微调模型,专为室内设计而设计。

被CVPR 2025录用为Highlight的ConsisID,是一种身份保持的文本到视频生成模型,基于CogVideoX-5B,通过频率分解在生成的视频中保持面部一致性。

VideoX-Fun基于CogVideoX的框架,支持灵活的分辨率(从512到1024)和多种启动方法(包括ComfyUI、WebUI以及Python)。

显然啊,在未来我们还将见证更多基于CogVideoX-5B微调的项目如火如荼地上线,充分发挥CogVideoX系列开源模型的力量。

听说智谱的全新开源模型也要上线了,包括基座模型、推理模型、沉思模型,这实在是太让人期待了!

原创文章,作者:猫爪社区,如若转载,请注明出处:https://www.meowzo.com/the-tech-behind-ai-generated-cat-and-mouse-is-from-a-chinese-company/